-

Video: Bí ẩn clip cô gái ngất xỉu tại chợ sau cuộc chạm trán chóng vánh với hai người lạ

Video: Bí ẩn clip cô gái ngất xỉu tại chợ sau cuộc chạm trán chóng vánh với hai người lạ -

Lời khai gây sốc về "luật 5%" và những túi tiền tỷ chuyển đến tay cựu Bộ trưởng Y tế Nguyễn Thị Kim Tiến

Lời khai gây sốc về "luật 5%" và những túi tiền tỷ chuyển đến tay cựu Bộ trưởng Y tế Nguyễn Thị Kim Tiến -

Vụ ô tô chở xe máy bốc cháy: Tiếng khóc của người tài xế nghèo trước gánh nặng nợ nần khi nuôi 3 con nhỏ và mẹ già đau ốm

Vụ ô tô chở xe máy bốc cháy: Tiếng khóc của người tài xế nghèo trước gánh nặng nợ nần khi nuôi 3 con nhỏ và mẹ già đau ốm -

Tường trình của cô giáo bị tố bắt học sinh liếm đất: Bất ngờ nguồn cơn, do học sinh tự đề xuất làm?

Tường trình của cô giáo bị tố bắt học sinh liếm đất: Bất ngờ nguồn cơn, do học sinh tự đề xuất làm? -

Đô vật 44 tuổi tử vong ở hội làng Sóc Sơn, Hà Nội: Hàng xóm chia sẻ điều bất ngờ về nạn nhân

Đô vật 44 tuổi tử vong ở hội làng Sóc Sơn, Hà Nội: Hàng xóm chia sẻ điều bất ngờ về nạn nhân -

5 Thượng tướng Quân đội thôi giữ chức vụ, nghỉ công tác từ ngày 1/3

5 Thượng tướng Quân đội thôi giữ chức vụ, nghỉ công tác từ ngày 1/3 -

Nóng: Cựu Bộ trưởng Y tế Nguyễn Thị Kim Tiến bị C03 đề nghị truy tố

Nóng: Cựu Bộ trưởng Y tế Nguyễn Thị Kim Tiến bị C03 đề nghị truy tố -

Cái kết đắng cho tài xế xe Porsche chạy 141 km/h trên cao tốc Cam Lâm - Vĩnh Hảo

Cái kết đắng cho tài xế xe Porsche chạy 141 km/h trên cao tốc Cam Lâm - Vĩnh Hảo -

Diễn biến mới vụ nữ sinh "ngủ nhầm phòng", mặc đồ gia chủ tại Hà Nội: Hai bên lên tiếng sau clip lan truyền

Diễn biến mới vụ nữ sinh "ngủ nhầm phòng", mặc đồ gia chủ tại Hà Nội: Hai bên lên tiếng sau clip lan truyền -

Danh tính người phụ nữ bị tàu hoả tông tử vong khi đi bộ trên đường ray, gia đình tiết lộ tình trạng sức khoẻ

Danh tính người phụ nữ bị tàu hoả tông tử vong khi đi bộ trên đường ray, gia đình tiết lộ tình trạng sức khoẻ

Công nghệ

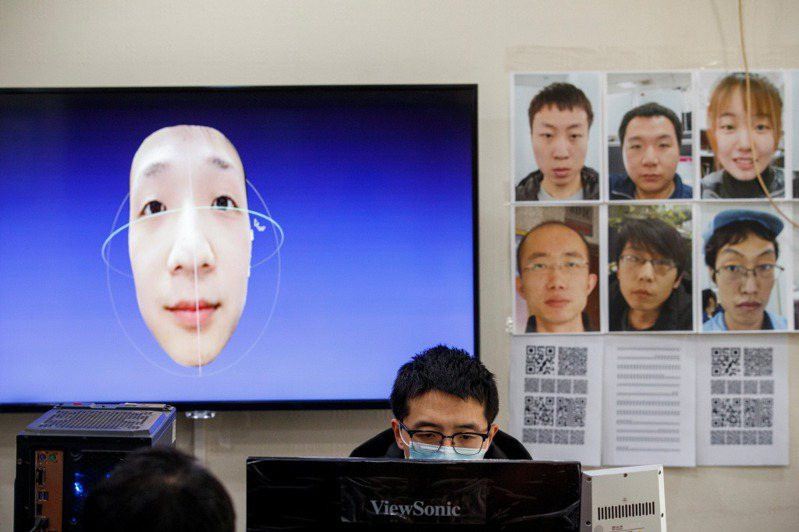

23/10/2023 14:22Deepfake đang bị lợi dụng để ghép mặt nạn nhân vào video khiêu dâm

Trong bối cảnh các tiến bộ công nghệ liên tục xuất hiện và định hình lại xã hội chúng ta đang sống, deepfake đang trở thành mối quan ngại lớn khi số lượng những vụ lừa đảo bằng deepfake ngày càng gia tăng.

Sau quá trình nghiên cứu trên diễn đàn darknet (darknet forum), nơi các tội phạm công nghệ thường xuyên hoạt động, trong một phát biểu mới đây, hãng bảo mật Kaspersky đưa ra nhận định, nhiều tội phạm sử dụng deepfake để lừa đảo, đến mức nhu cầu sử dụng vượt xa nguồn cung các phần mềm deepfake hiện có trên thị trường.

Khi cầu vượt cung, các chuyên gia của Kaspersky dự đoán, các vụ lừa đảo bằng deepfake sẽ tăng cao với nhiều hình thức đa dạng và tinh vi hơn. Từ cung cấp một video mạo danh chất lượng cao dưới dạng dịch vụ cho đến việc sử dụng hình ảnh người nổi tiếng để phát trực tuyến giả mạo (fake livestream) trên mạng xã hội cùng lời hứa hẹn sẽ thanh toán gấp đôi số tiền nạn nhân đã gửi họ.

“Deepfake đã trở thành cơn ác mộng đối với phụ nữ và xã hội. Tội phạm mạng hiện đang khai thác AI để ghép khuôn mặt nạn nhân vào ảnh và video khiêu dâm cũng như trong chiến dịch tuyên truyền. Chúng tôi kêu gọi công chúng nâng cao cảnh giác trước mối đe dọa này”, bà Võ Dương Tú Diễm, Giám đốc khu vực Việt Nam của Kaspersky nhận định.

Bà Diễm cho rằng, những hành động trên nhằm mục đích thao túng dư luận bằng cách phát tán thông tin sai lệch gây tổn hại đến danh tiếng của tổ chức hoặc cá nhân.

Theo Regula, có tới 37% doanh nghiệp trên toàn thế giới từng có va chạm với các vụ lừa đảo deepfake bằng giọng nói và 29% đã trở thành nạn nhân của video deepfake.

Trên thực tế, deepfake cũng đã trở thành mối đe dọa với Việt Nam khi tội phạm mạng thường sử dụng các cuộc gọi video deepfake để mạo danh một cá nhân và vay mượn người thân, bạn bè của họ. Một cuộc gọi video deepfake chỉ diễn ra trong vòng một phút nên nạn nhân rất khó phân biệt giữa cuộc gọi thật và giả.

Mặc AI đang bị tội phạm mạng sử dụng cho những mục đích xấu, vẫn có thể sử dụng chính AI để nhận diện deepfake nhằm giảm thiểu xác suất thành công của các vụ lừa đảo.

Những phần mềm phát hiện nội dung do AI tạo ra sẽ sử dụng thuật toán tiên tiến để phân tích và xác định mức độ bị chỉnh sửa của tệp hình ảnh, video, âm thanh. Đó có thể là việc nhận diện sự chuyển động không khớp giữa khuôn miệng và lời thoại hay lưu lượng máu bất thường dưới da bằng cách phân tích độ phân giải của video vì khi tim bơm máu, tĩnh mạch của con người sẽ đổi màu.

Theo các chuyên gia của Kaspersky, bên cạnh việc sử dụng các công cụ AI để nhận diện deepfake, người dùng cũng cần có những biện pháp phù hợp để bảo vệ bản thân. Đó có thể là hạn chế chia sẻ thông tin cá nhân công khai trên các trang mạng xã hội hay cảnh giác trước những video, hình ảnh, cuộc gọi có dấu hiệu đáng ngờ. Ngoài ra, người dùng mạng cũng cần duy trì thói quen kiểm chứng, xác thực lại thông tin trước khi đặt niềm tin vào đó.

Theo Trọng Đạt (VietNamNet)

- Jack cán mốc 1 tỷ lượt xem (06:21)

- Wolves tạo địa chấn, Aston Villa ôm hận trong mưa ở Molineux (06:17)

- Tử vi thứ 7 ngày 28/2/2026 của 12 con giáp: Tý có biến động ngầm, Ngọ sáng tạo (06:00)

- Cháy tàu du lịch ở Quảng Ninh: Quyết định kịp thời của thuyền trưởng cứu sống toàn bộ 41 người (27/02/26 23:00)

- "Cha đẻ" dầu gội X-men bất ngờ ngồi ghế Tổng giám đốc PNJ: Chân dung nhà điều hành có profile khủng (27/02/26 22:46)

- Hà Nội: 2 vợ chồng thương vong trên đường đi thăm con gái mới sinh, camera ghi lại diễn biến sự việc (27/02/26 22:28)

- Hà Nội sẽ chuyển toàn bộ taxi chạy xăng, dầu sang xe điện trước 2030 (27/02/26 22:15)

- Kiểm tra 2 kho lạnh ở Thanh Hóa: Phát hiện gần 6 tấn đuôi, chân trâu bò bốc mùi khó chịu (27/02/26 22:01)

- Vụ thanh niên đánh mẹ gãy tay ở Nghệ An: Công an tiếp tục triệu tập những người liên quan (27/02/26 21:38)

- Tàu du lịch chở 41 người cháy ngùn ngụt trên vịnh Hạ Long (27/02/26 21:30)