-

Nam thanh niên hiếp dâm bé gái 13 tuổi sau cuộc nhậu ngày mùng 1 Tết

Nam thanh niên hiếp dâm bé gái 13 tuổi sau cuộc nhậu ngày mùng 1 Tết -

Hà Nội áp dụng khung giá dịch vụ chung cư mới từ 23/2

Hà Nội áp dụng khung giá dịch vụ chung cư mới từ 23/2 -

Tử vi thứ 5 ngày 19/2/2026 của 12 con giáp: Mùng 3 Tết Sửu như ý, Thìn ăn lộc lớn

Tử vi thứ 5 ngày 19/2/2026 của 12 con giáp: Mùng 3 Tết Sửu như ý, Thìn ăn lộc lớn -

Thưởng thức Bánh chưng ngày Tết: Làm sao để không "làm khó" huyết áp?

Thưởng thức Bánh chưng ngày Tết: Làm sao để không "làm khó" huyết áp? -

Tài tử "Transformers" Shia LaBeouf bị vợ phũ phàng dứt tình ngay mùng 2 Tết sau bê bối bạo lực

Tài tử "Transformers" Shia LaBeouf bị vợ phũ phàng dứt tình ngay mùng 2 Tết sau bê bối bạo lực -

Chi tiết lịch nghỉ lễ, Tết năm 2026: Người lao động đón "cơn mưa" ngày nghỉ lên tới 26 ngày

Chi tiết lịch nghỉ lễ, Tết năm 2026: Người lao động đón "cơn mưa" ngày nghỉ lên tới 26 ngày -

Danh tính người đàn ông ẩn danh đăng bài bôi xấu lực lượng công an, nhận cái kết đắng ngày đầu năm

Danh tính người đàn ông ẩn danh đăng bài bôi xấu lực lượng công an, nhận cái kết đắng ngày đầu năm -

Tổng Bí thư Tô Lâm lên đường dự Hội đồng Hòa bình về Gaza tại Mỹ

Tổng Bí thư Tô Lâm lên đường dự Hội đồng Hòa bình về Gaza tại Mỹ -

Giờ đẹp hóa vàng Tết Bính Ngọ 2026: Bí quyết nghênh đón tài lộc, tiễn đưa gia tiên

Giờ đẹp hóa vàng Tết Bính Ngọ 2026: Bí quyết nghênh đón tài lộc, tiễn đưa gia tiên -

Ngã ngũ vụ bê bối nhập tịch: Malaysia "ngầm thừa nhận" gian lận, tuyển Việt Nam sắp hưởng lợi lớn

Ngã ngũ vụ bê bối nhập tịch: Malaysia "ngầm thừa nhận" gian lận, tuyển Việt Nam sắp hưởng lợi lớn

Công nghệ

06/08/2021 22:48Apple quét iPhone, iCloud tìm ảnh lạm dụng trẻ em

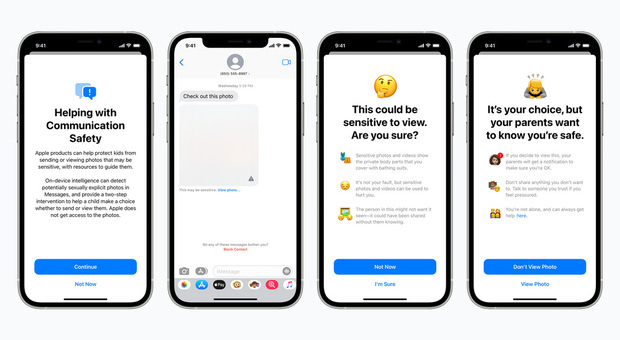

Cuối năm nay, Apple sẽ ra mắt công nghệ cho phép công ty phát hiện và báo cáo nội dung lạm dụng tình dục trẻ em (CSAM) cho nhà hành pháp. Trả lời TechCrunch, “Táo Khuyết” cho biết đây là một trong vài tính năng mới nhằm bảo vệ trẻ em tốt hơn trước các nguy cơ trực tuyến, bao gồm bộ lọc chặn hình ảnh khiêu dâm gửi và nhận qua tài khoản iMessage của trẻ. Một tính năng khác sẽ can thiệp khi người dùng cố tìm kiếm các từ khóa liên quan tới CSAM trên Siri và Search.

Tin tức về nỗ lực mới của Apple bị lộ ra sau khi Matthew Green, một giảng viên Mật mã học tại Đại học John Hopkins, đăng lên Twitter. Không chỉ vấp phải phản ứng từ một số nhà hoạt động quyền riêng tư và chuyên gia bảo mật, Apple còn bị người dùng phản đối. Theo Apple, công nghệ phát hiện CSAM mới - NeuralHash - sẽ hoạt động trên thiết bị người dùng và có thể phát hiện khi người dùng tải ảnh lạm dụng trẻ em lên iCloud mà không cần giải mã hình ảnh.

Apple đang cố xoa dịu cơn tức giận từ mọi người bằng cách nhấn mạnh tới nhiều lớp mã hóa để đảm bảo quyền riêng tư. NeuralHash sẽ có mặt trên iOS 15 và macOS Monterey trong 1 hoặc 2 tháng tới. Nó hoạt động bằng cách chuyển đổi hình ảnh trên iPhone hoặc Mac thành một chuỗi ký tự và số độc nhất vô nhị (hash). Bất cứ khi nào thay đổi hình ảnh, hash cũng thay đổi. NeuralHash muốn bảo đảm hình ảnh gốc và hình ảnh tương tự - chẳng hạn đã cắt cúp và qua chỉnh sửa - đều có chung hash.

Trước khi ảnh được tải lên iCloud Photos, các hash trên thiết bị sẽ được đối chiếu với một cơ sở dữ liệu các hash về ảnh lạm dụng trẻ em do các tổ chức bảo vệ trẻ em cung cấp. NeuralHash sử dụng kỹ thuật mật mã có tên private set intersection để phát hiện các hash khớp mà không tiết lộ hình ảnh là gì hay cảnh báo người dùng.

Apple có thể giải mã hình ảnh, xác minh thủ công nội dung, vô hiệu hóa tài khoản người dùng và báo cáo hình ảnh cho nhà chức trách. Theo công ty, tỉ lệ sai sót là 1/1.000 tỷ nhưng sẽ có quy trình kháng nghị.

Dù vậy, nhiều người cảm thấy không thoải mái khi trao dữ liệu cho một thuật toán. Vài chuyên gia bảo mật kêu gọi cần thảo luận trước công chúng trước khi Apple triển khai công nghệ này.

Theo Du Lam (ICTNews)

- Nam thanh niên hiếp dâm bé gái 13 tuổi sau cuộc nhậu ngày mùng 1 Tết (20 phút trước)

- Hà Nội áp dụng khung giá dịch vụ chung cư mới từ 23/2 (30 phút trước)

- Cái kết vụ ô tô đỗ chắn ngõ, điều thêm xe khóa đầu đuôi, chủ xe tuyên bố "công an là bạn anh hết" (38 phút trước)

- iPhone Air giờ chỉ dưới 20 triệu đồng, một camera xài đủ không, pin có khoẻ không, có nên chốt mua không? (2 giờ trước)

- Chị chồng cấm tôi dự đám cưới vì khinh tôi nghèo… Nhưng khi chú rể gặp tôi, anh ta vội cúi đầu... (2 giờ trước)

- Vụ ném mìn vào nhà anh vợ ngày mùng 2 Tết: Nghi phạm đã tự tử (3 giờ trước)

- Bắt gã đàn ông cướp giật tài sản khiến 2 người phụ nữ thương vong mùng 2 Tết, hiện trường thương tâm (3 giờ trước)

- Danh tính 3 nạn nhân thương vong trên đường đi chúc Tết, hé lộ diễn biến đau lòng (3 giờ trước)

- Chủ xe, tài xế bị phạt 200 triệu sau tin nhắn Zalo từ người dân (3 giờ trước)

- Giá xăng ngày mai 20/2 có thể tăng lần thứ 4 liên tiếp (4 giờ trước)